Heat_PINN¶

| 预训练模型 | 指标 |

|---|---|

| heat_pinn_pretrained.pdparams | norm MSE loss between the FDM and PINN is 1.30174e-03 |

1. 背景简介¶

热传导是自然界中的常见现象,广泛应用于工程、科学和技术领域。热传导问题在多个领域中都具有广泛的应用和重要性,对于提高能源效率、改进材料性能、促进科学研究和推动技术创新都起着至关重要的作用。因此了解和模拟传热过程对于设计和优化热传导设备、材料和系统至关重要。2D 定常热传导方程描述了稳态热传导过程,传统的求解方法涉及使用数值方法如有限元法或有限差分法,这些方法通常需要离散化领域并求解大规模矩阵系统。近年来,基于物理信息的神经网络(Physics-informed neural networks, PINN)逐渐成为求解偏微分方程的新方法。PINN 结合了神经网络的灵活性和对物理约束的建模能力,能够直接在连续领域中解决偏微分方程问题。

2. 问题定义¶

假设二维热传导方程中,每个位置 \((x,y)\) 上的温度 \(T\) 满足以下关系式:

并且在以下区域内:

具有以下边界条件:

3. 问题求解¶

接下来开始讲解如何将问题一步一步地转化为 PaddleScience 代码,用深度学习的方法求解该问题。 为了快速理解 PaddleScience,接下来仅对模型构建、方程构建、计算域构建等关键步骤进行阐述,而其余细节请参考 API文档。

3.1 模型构建¶

在二维热传导问题中,每一个已知的坐标点 \((x, y)\) 都有对应的待求解的未知量 \(T\) ,我们在这里使用比较简单的 MLP(Multilayer Perceptron, 多层感知机) 来表示 \((x, y)\) 到 \(u\) 的映射函数 \(f: \mathbb{R}^2 \to \mathbb{R}^1\) ,即:

上式中 \(f\) 即为 MLP 模型本身,用 PaddleScience 代码表示如下

为了在计算时,准确快速地访问具体变量的值,我们在这里指定网络模型的输入变量名是 ("x", "y"),输出变量名是 "u",这些命名与后续代码保持一致。

接着通过指定 MLP 的层数、神经元个数和激活函数,我们就实例化出了一个拥有 9 层隐藏神经元、每层神经元数为 20 以及激活函数为 tanh 的神经网络模型 model。

3.2 方程构建¶

由于二维热传导方程使用的是 Laplace 方程的 2 维形式,因此可以直接使用 PaddleScience 内置的 Laplace,指定该类的参数 dim 为 2。

3.3 计算域构建¶

本文中二维热传导问题作用在以 (-1.0, -1.0), (1.0, 1.0) 为对角线的二维矩形区域,

因此可以直接使用 PaddleScience 内置的空间几何 Rectangle 作为计算域。

3.4 约束构建¶

在本案例中,我们使用了两种约束条件在计算域中指导模型的训练分别是作用于采样点上的热传导方程约束和作用于边界点上的约束。

在定义约束之前,需要给每一种约束指定采样点个数,表示每一种约束在其对应计算域内采样数据的数量,以及通用的采样配置。

3.4.1 内部点约束¶

以作用在内部点上的 InteriorConstraint 为例,代码如下:

InteriorConstraint 的第一个参数是方程表达式,用于描述如何计算约束目标,此处填入在 3.2 方程构建 章节中实例化好的 equation["Laplace"].equations;

第二个参数是约束变量的目标值,根据热传导方程的定义,我们希望 Laplace 方程产生的结果全为 0;

第三个参数是约束方程作用的计算域,此处填入在 3.3 计算域构建 章节实例化好的 geom["rect"] 即可;

第四个参数是在计算域上的采样配置,此处我们使用全量数据点训练,因此 dataset 字段设置为 "IterableNamedArrayDataset" 且 iters_per_epoch 也设置为 1,采样点数 batch_size 设为 NPOINT_PDE(表示99x99的采样网格);

第五个参数是损失函数,此处我们选用常用的MSE函数,且 reduction 设置为 "mean",即我们会将参与计算的所有数据点产生的损失项求平均;

第六个参数是计算 loss 的时候的该约束的权值大小,参考PINN论文,这里我们设置为 1;

第七个参数是选择是否在计算域上进行等间隔采样,此处我们选择开启等间隔采样,这样能让训练点均匀分布在计算域上,有利于训练收敛;

第八个参数是约束条件的名字,我们需要给每一个约束条件命名,方便后续对其索引。此处我们命名为 "EQ" 即可。

3.4.2 边界约束¶

同理,我们还需要构建矩形的四个边界的约束。但与构建 InteriorConstraint 约束不同的是,由于作用区域是边界,因此我们使用 BoundaryConstraint 类,代码如下:

BoundaryConstraint 类第一个参数表示我们直接对网络模型的输出结果 out["u"] 作为程序运行时的约束对象;

第二个参数是指我们约束对象的真值为多少,该问题中边界条件为 Dirichlet 边界条件,也就是该边界条件直接描述物理系统边界上的物理量,给定一个固定的边界值,具体的边界条件值已在 2. 问题定义 中给出;

BoundaryConstraint 类其他参数的含义与 InteriorConstraint 基本一致,这里不再介绍。

在微分方程约束和边界约束构建完毕之后,以我们刚才的命名为关键字,封装到一个字典中,方便后续访问。

3.5 优化器构建¶

训练过程会调用优化器来更新模型参数,此处选择较为常用的 Adam 优化器,并设置学习率为 0.0005。

3.6 模型训练¶

完成上述设置之后,只需要将所有上述实例化的对象按顺序传递给 ppsci.solver.Solver,然后启动训练。

3.7 模型评估、可视化¶

模型训练完成之后就需要进行与正式 FDM 方法计算出来的结果进行对比,这里我们使用了 geom["rect"].sample_interior 采样出测试所需要的坐标数据。

然后,再将采样出来的坐标数据输入到模型中,得到模型的预测结果,最后将预测结果与 FDM 结果进行对比,得到模型的误差。

4. 完整代码¶

| heat_pinn.py | |

|---|---|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 123 124 125 126 127 128 129 130 131 132 133 134 135 136 137 138 139 140 141 142 143 144 145 146 147 148 149 150 151 152 153 154 155 156 157 158 159 160 161 162 163 164 165 166 167 168 169 170 171 172 173 174 175 176 177 178 179 180 181 182 183 184 185 186 187 188 189 190 191 192 193 194 195 196 197 198 199 200 201 202 203 204 205 206 207 208 209 210 211 212 213 214 215 216 217 218 219 220 221 222 223 224 225 226 227 228 229 230 231 232 233 234 235 236 237 238 239 240 241 242 243 244 245 246 247 248 249 250 251 252 253 254 255 256 257 258 259 260 261 262 263 264 265 266 267 268 269 270 271 272 273 274 275 276 277 278 279 280 281 282 283 284 285 286 287 288 289 290 291 292 293 294 295 296 297 298 299 300 301 302 303 304 305 306 307 308 309 310 311 312 313 314 315 316 317 318 319 320 321 | |

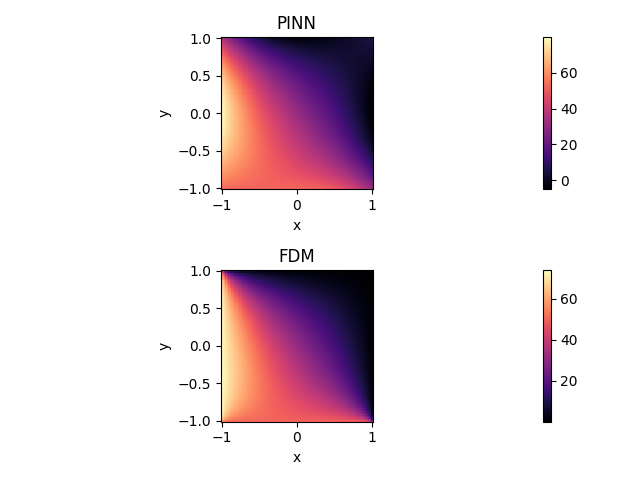

5. 结果展示¶

上图展示了使用 PINN 和 FDM 方法分别计算出的温度分布图,从中可以看出它们之间的结果非常接近。此外,PINN 和 FDM 两者之间的均方误差(MSE Loss)仅为 0.0013。综合考虑图形和数值结果,可以得出结论,PINN 能够有效地解决本案例的传热问题。

上图分别为温度 \(T\) 的横截线图( \(y=\{-0.75,-0.50,-0.25,0.00,0.25,0.50,0.75\}\) )和纵截线图( \(x=\{-0.75,-0.50,-0.25,0.00,0.25,0.50,0.75\}\) ),可以看到 PINN 与 FDM 方法的计算结果基本一致。